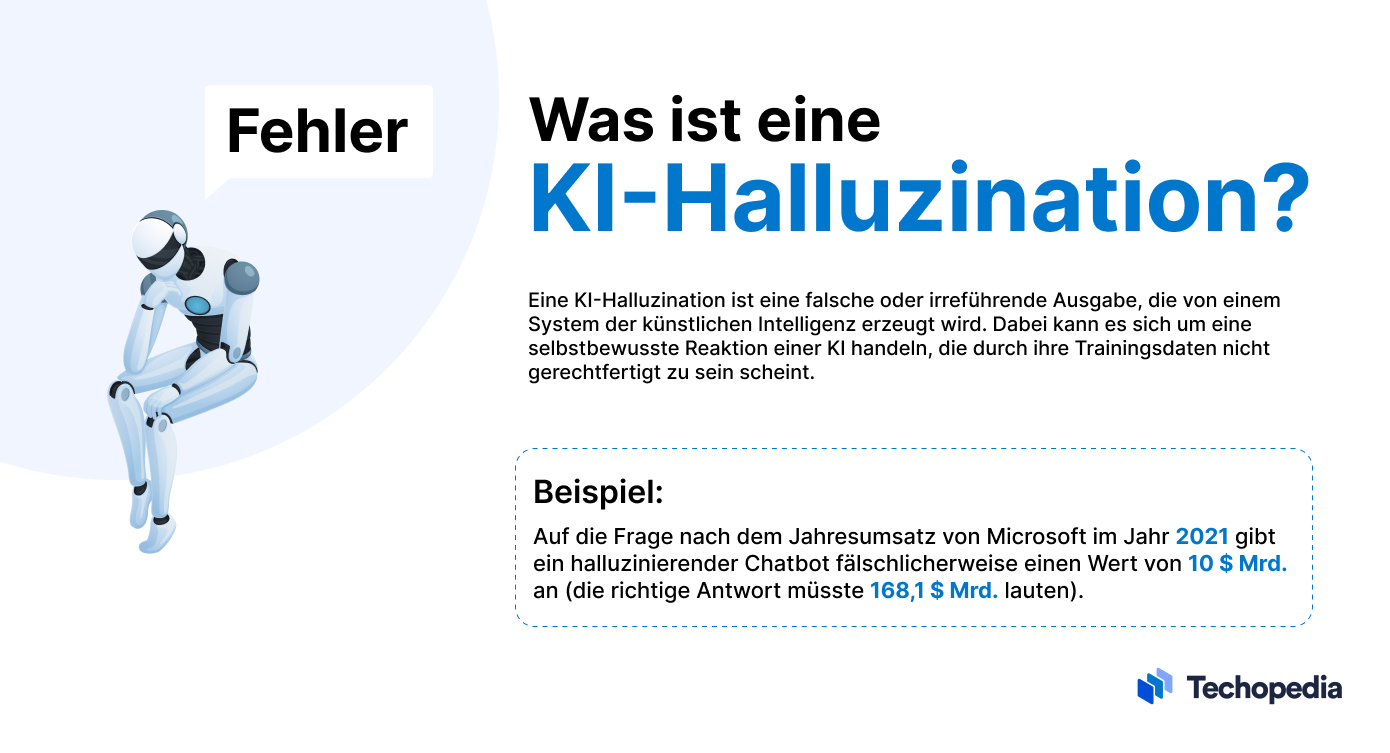

Was ist KI-Halluzination?

Eine KI-Halluzination liegt vor, wenn ein großes Sprachmodell (engl. Large Language Model, LLM) wie GPT-4 von OpenAI oder Google PaLM falsche Informationen oder Fakten erfindet, die nicht auf realen Daten oder Ereignissen beruhen.

Avivah Litan, VP Analyst bei Gartner, erklärt:

„Halluzinationen sind komplett erfundene Ausgaben von großen Sprachmodellen. Obwohl sie völlig ausgedachte Fakten darstellen, präsentiert das LLM sie mit Vertrauen und Autorität.“

Chatbots mit generativer KI können jede Art von Sachinformation fabrizieren, von Namen, Daten und historischen Ereignissen bis hin zu Zitaten oder sogar Code.

Halluzinationen sind so häufig, dass OpenAI sogar eine Warnung an die Benutzer von ChatGPT ausgibt, die besagt, dass „ChatGPT ungenaue Informationen über Personen, Orte oder Fakten produzieren kann“.

Dabei ist es für die Nutzer eine Herausforderung, zu erkennen, welche Informationen wahr sind und welche nicht.

Beispiele für KI-Halluzinationen

Es gibt zwar viele Beispiele für KI-Halluzinationen, aber einer der bemerkenswertesten Fälle ereignete sich im Rahmen eines Werbevideos, das Google im Februar 2023 veröffentlichte.

Damals behauptete der KI-Chatbot Bard fälschlicherweise, das James-Webb-Weltraumteleskop habe das erste Bild eines Planeten außerhalb des Sonnensystems aufgenommen.

In der Launch-Demo der KI von Microsoft Bing im Februar 2023 analysierte das Programm eine Ergebnisrechnung von Gap und lieferte eine falsche Zusammenfassung von Fakten und Zahlen.

Diese Beispiele zeigen, dass die Nutzer nicht darauf vertrauen können, dass Chatbots immer wahrheitsgemäße Antworten geben. Die Risiken, die von KI-Halluzinationen ausgehen, reichen jedoch weit über die Verbreitung von Fehlinformationen hinaus.

Laut dem Forschungsteam von Vulcan Cyber kann ChatGPT sogar URLs, Verweise und Codebibliotheken generieren, die nicht existieren, oder ahnungslosen Usern potenziell bösartige Softwarepakete empfehlen.

Daher müssen Unternehmen und Nutzer, die mit LLMs und generativer KI experimentieren, bei der Arbeit mit diesen Lösungen ihre Sorgfaltspflicht erfüllen und die Ergebnisse auf ihre Genauigkeit hin überprüfen.

Was sind die Ursachen für KI-Halluzinationen?

Einige der wichtigsten Faktoren für KI-Halluzinationen sind:

- Veraltete oder mangelhafte Trainingsdaten;

- Falsch klassifizierte oder beschriftete Daten;

- Faktenfehler, Widersprüchlichkeiten oder Verzerrungen in den Trainingsdaten;

- Unzureichende Programmierung, um Informationen korrekt zu interpretieren;

- Fehlender Kontext, der vom Benutzer bereitgestellt wird;

- Schwierigkeiten, die Absicht bei Umgangssprache, Slangausdrücken oder Sarkasmus zu erkennen.

Es ist wichtig, die Prompts in einfacher Sprache und so detailliert wie möglich zu formulieren.

Daher liegt es letztendlich in der Verantwortung des Anbieters, eine ausreichende Programmierung und Leitplanken zu implementieren, um das Potenzial für Halluzinationen zu verringern.

Zum Thema: KI-Prompts schreiben: ChatGPT, Bard, Bing und Co mit Beispielen

Was sind die Gefahren von KI-Halluzinationen?

Eines der Hauptrisiken der KI-Halluzination besteht darin, dass der Nutzer zu sehr auf die Genauigkeit der Ergebnisse des KI-Systems vertraut.

Während einige Personen wie der CEO von Microsoft, Satya Nadella, argumentiert haben, KI-Systeme wie Microsoft Copilot könnten „nützlich falsch“ sein, besteht die Gefahr, dass diese Lösungen Fehlinformationen und hasserfüllte Inhalte verbreiten, wenn sie nicht kontrolliert werden.

LLM-generierte Fehlinformationen sind schwer zu bewältigen. Grund dafür ist, dass diese Lösungen Inhalte generieren können, die beim Dienst detailliert, überzeugend und zuverlässig aussehen, in Wirklichkeit aber falsch sind. Die Folge ist, dass der Nutzer an unwahre Fakten und Informationen glaubt.

Nimmt man KI-generierte Inhalte für bare Münze, besteht die Gefahr, dass sich falsche und unwahre Informationen im gesamten Internet verbreiten.

Und schließlich besteht auch das Risiko rechtlicher Verpflichtungen und der Einhaltung von Vorschriften.

Wenn ein Unternehmen beispielsweise einen LLM-gestützten Dienst für die Kommunikation mit Kunden einsetzt, der Anleitungen herausgibt, die dem Eigentum des Nutzers schaden, oder beleidigende Inhalte verbreitet, dann könnte es rechtliche Schritte riskieren.

Wie kann man KI-Halluzinationen erkennen?

Ob ein KI-System halluziniert, kann man am besten durch manuelle Überprüfung der von der Lösung gelieferten Daten mit einer Drittquelle feststellen.

Der Abgleich von Fakten, Zahlen und Argumenten mit Nachrichtenseiten, Branchenberichten, Studien und Büchern über eine Suchmaschine kann dabei helfen, die Genauigkeit von Informationen zu bewerten.

Eine manuelle Überprüfung ist eine gute Option für Benutzer, die Fehlinformationen aufspüren möchten. In einer Unternehmensumgebung ist es jedoch möglicherweise logistisch oder wirtschaftlich nicht sinnvoll, jeden Inhalt zu kontrollieren.

Aus diesem Grund sollte man den Einsatz automatisierter Tools zur Überprüfung von generativen KI-Lösungen auf Halluzinationen in Betracht ziehen.

So kann beispielsweise das Open-Source-Tool NeMo Guardrails von Nvidia Halluzinationen durch den Vergleich der Ausgabe eines LLM mit der eines anderen identifizieren.

In ähnlicher Weise bietet Got It AI eine Lösung namens TruthChecker an, bei der KI zur Erkennung von Halluzinationen in GPT-3.5+ generierten Inhalten eingesetzt wird.

Natürlich sollten Unternehmen, die mithilfe automatisierter Tools wie Nemo Guardrails und Got It AI KI-Systeme auf Fakten überprüfen, sorgfältig testen, wie effektiv diese Lösungen bei der Erkennung von Fehlinformationen sind.

Zudem sollten sie eine Risikobewertung durchführen, um festzustellen, ob weitere Maßnahmen ergriffen werden müssen, um eine mögliche Haftung auszuschließen.

Fazit

KI und LLM können Unternehmen einige interessante Möglichkeiten bieten. Um jedoch die besten Ergebnisse zu erzielen, müssen sich die Nutzer der Risiken und Grenzen dieser Technologien bewusst sein.

Letztendlich sind KI-Lösungen am wertvollsten, wenn sie die menschliche Intelligenz ergänzen, anstatt sie zu ersetzen.

Sofern sich Nutzer und Unternehmen darüber im Klaren sind, dass LLMs Informationen fälschen und Ausgabedaten anderweitig verifizieren können, wird das Risiko der Verbreitung oder Aufnahme von Fehlinformationen minimiert.